Les robots et l’intelligence artificielle existent depuis bien longtemps, certains affirment même que ces concepts remontent à la mythologie grecque.

Cet article porte essentiellement sur la période à laquelle les machines ont réellement commencé à interagir avec les êtres humains, aux alentours de 1950.

Apprenez à créer votre premier bot avec SenMarketing Digital

Au-delà des références propres au domaine de la fiction, il explore en détail la notion de robot et retrace le cheminement de cette dernière jusqu’à aujourd’hui, une époque dans laquelle, bon gré mal gré, les bots sont devenus essentiels à certaines tâches du quotidien.

Qu’est-ce qu’un bot ?

Un bot est une technologie automatisée qui est programmée pour exécuter certaines tâches sans intervention humaine. Autrement dit, l’être humain peut être l’instigateur d’une action, mais le bot est capable d’effectuer cette action seul.

Les bots sont une forme d’intelligence artificielle, une technologie capable de reproduire des facultés dont seuls les êtres humains sont capables, notamment parler, voir, apprendre, socialiser et raisonner.

Ainsi, un grand nombre de bots qui font à présent partie de notre quotidien, tels que Siri et l’Assistant Google, sont dotés d’une intelligence artificielle qui leur permet de former des réponses comme le ferait un interlocuteur humain.

Une grande partie de la population a régulièrement recours à ces machines virtuelles : par exemple, une étude montre que 55 % des personnes qui on un téléphone portable utilisent l’assistance vocale chaque jour ou chaque semaine. Elles sont devenues des solutions ordinaires à divers besoins, comme dans le domaine du service client.

Un bref aperçu de l’origine des bots

Les bots semblent être un phénomène récent, mais en réalité, ils reposent sur plus de 70 ans de travail.

Les années 50

Le test de Turing

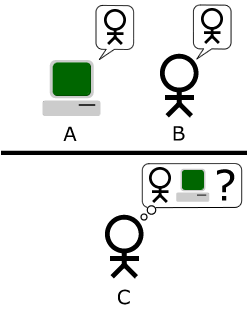

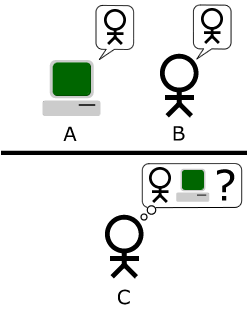

En 1950, l’informaticien et mathématicien Alan Turing a conçu un test éponyme, aussi connu sous le nom de jeu de l’imitation. Son format le plus basique nécessitait trois participants (A, B et C).

- Les participants A et B étaient respectivement une machine et un être humain.

- Le participant C, humain lui aussi, jouait le rôle d’interrogateur et saisissait des questions sur un ordinateur.

- Le participant C recevait les réponses des participants A et B.

- L’objectif était pour le participant C de déterminer lequel de ses deux interlocuteurs était humain.

Image par Bilby — Travail personnel, Domaine public, Lien

Cependant, la méthode présentait un problème. À l’époque, les bases de données étaient extrêmement limitées et elles ne pouvaient stocker qu’un nombre limité d’expressions. Par conséquent, l’ordinateur finissait par manquer de réponses à donner au participant C, ce qui entravait l’exercice et coupait court au test.

Un test encore d’actualité, mais sujet de controverse

En 2014, l’université de Reading a organisé un test de Turing au cours duquel un panel de 30 juges a joué le rôle du participant C. Si la machine parvenait, dans plus de 30 % des échanges, à persuader l’ensemble des juges que ses réponses venaient d’un être humain, le test serait considéré comme réussi.

C’est exactement ce qui s’est produit. Un programme d’intelligence artificielle baptisé Eugene Goostman, se faisant passer pour un garçon de 13 ans en Ukraine, a convaincu 33 % des juges.

D’après l’université, c’était la première fois qu’une IA réussissait le test de Turing. Toutefois, ces résultats, qui ont suscité autant de louanges que de critiques, ont défrayé la chronique dans de nombreux médias. Beaucoup se sont montrés sceptiques quant aux aptitudes d’Eugene Goostman, s’interrogeant sur leur supposée supériorité par rapport aux formes les plus rudimentaires d’IA.

Quoi qu’il en soit, Alan Turing fait, à juste titre, figure de pionnier de l’intelligence artificielle, puisqu’il paraît avoir déclenché une succession d’événements ayant mené à l’IA que l’on connaît aujourd’hui.

C’est à peine cinq ans plus tard, en 1956, que s’est tenue la conférence de Dartmouth sur l’IA à l’initiative de John McCarthy, le professeur de mathématiques qui a inventé le terme d’intelligence artificielle. Suite à ce colloque, l’université a fait de l’IA l’une de ses disciplines de recherche.

En 1958, alors qu’il enseignait au MIT, John McCarthy a développé le langage de programmation LISP, qui est à l’époque devenu la référence en matière d’IA, et qui pour certains, l’est encore aujourd’hui. De nombreux acteurs du secteur, notamment l’informaticien Alan Kay, décrivent LISP comme le meilleur langage de programmation jamais inventé.

Les années 1960

ELIZA

L’une des plus grandes avancées de l’IA dans les années 1960 a été l’élaboration d’ELIZA. Ce programme, dont le nom s’inspire en partie du personnage de la pièce Pygmalion, avait pour fonction de simuler un entretien avec un psychothérapeute.

Conçue en 1966 par Joseph Weizenbaum, professeur au MIT, cette technologie était pour le moins limitée, tout comme son vocabulaire. Cependant, Weizenbaum savait que des progrès étaient encore possibles, comparant même ELIZA à une personne « aux connaissances linguistiques limitées, mais très à l’écoute ».

Ces premières inventions ont clairement montré que les êtres humains désirent interagir avec la technologie de la même manière qu’ils communiquent entre eux. Mais à l’époque, les connaissances technologiques n’étaient pas suffisantes pour y parvenir.

À cette contrainte est venu s’ajouter le rapport ALPAC de 1966, qui a fait preuve d’un grand scepticisme à l’égard de l’apprentissage automatique et préconisé l’abandon de tout financement public en faveur de la recherche en intelligence artificielle.

Nombreux sont ceux qui, au vu des maigres avancées réalisées durant le reste de la décennie, reprochent à la publication de ce rapport aux États-Unis d’avoir limité toute progression majeure dans le domaine jusque dans les années 1970.

À noter tout de même, parmi les quelques développements de la fin des années 1960, l’invention de l’institut de recherche de Stanford : Shakey, un robot plus ou moins autonome, « doté de compétences linguistiques limitées ».

La première conférence internationale sur l’intelligence artificielle s’est également tenue en 1969 (et a lieu encore aujourd’hui), mais le regain d’intérêt pour l’IA a tardé à suivre.

Les années 1970 et 1980

Freddy

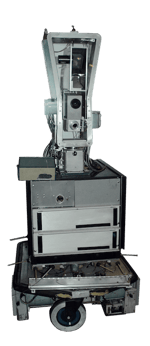

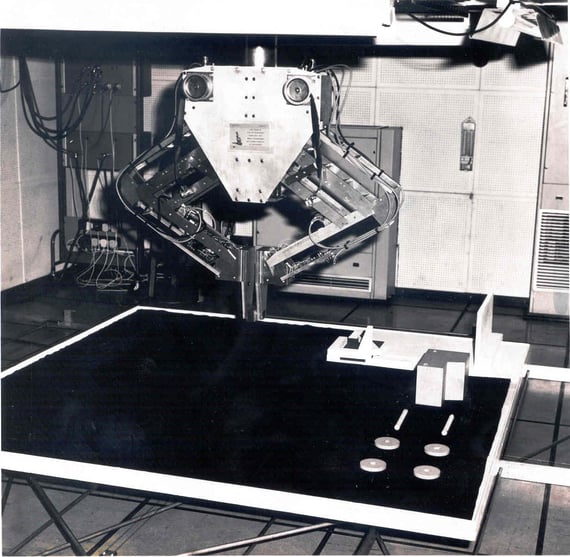

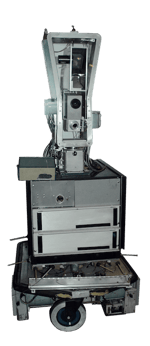

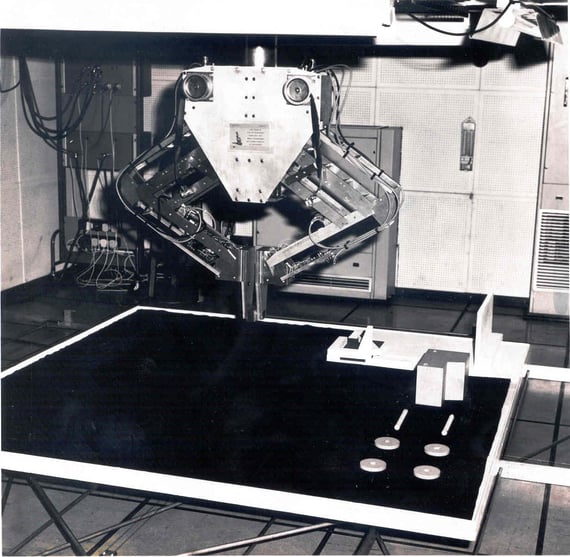

Au début des années 1970, Freddy a fait parler de lui, ce robot dépourvu de parole conçu par les chercheurs de l’université d’Édimbourg. Bien qu’incapable de communiquer avec les êtres humains, il pouvait assembler des objets simples sans aucune aide.

L’innovation de cette machine résidait dans sa capacité à utiliser la vue pour exécuter des tâches, grâce à une caméra qui lui permettait de voir et de reconnaître les pièces d’assemblage. Toutefois, Freddy n’était pas la plus rapide des inventions ; il lui fallait près de 16 heures pour accomplir ces tâches.

Source: le musée national d’Écosse

La robotique et la médecine

Les années 1970 ont également vu les toutes premières intégrations des bots dans la médecine. MYCIN, développé en 1972 à l’école de médecine de Stanford, reposait sur un système expert pour identifier les maladies infectieuses chez les patients.

Le programme posait des questions comparables à celles d’un médecin pour rassembler des informations de diagnostic, puis consultait une base de données compilées par des experts pour trouver des réponses.

S’ensuivit au milieu des années 1970 la création d’INTERNIST-1, un système similaire élaboré par l’université de Pittsburgh. Il est intéressant ici de noter que celui-ci s’appuyait sur le langage LISP du professeur McCarthy.

INTERNIST-1 est par la suite devenu Quick Medical Reference, « un système d’aide à la prise de décision » proposant de multiples diagnostics. Cette technologie a depuis été abandonnée.

L’élargissement des discussions au sujet des bots

Le début des années 1980 a été marqué par la tenue de réunions plus larges au sujet de l’IA, dont la première conférence de l’AAAI, l’association américaine pour l’intelligence artificielle. Cette décennie a aussi été celle du lancement d’AARON.

Ce robot était capable de créer des œuvres originales abstraites et figuratives, qui ont notamment été exposées à la Tate Modern, au Stedelijk Museum et au musée d’Art Moderne de San Francisco.

Si le sujet des voitures autonomes est aujourd’hui beaucoup abordé, la technologie sur laquelle elles reposent remonte en réalité aux années 80.

En 1989, le professeur Dean Pomerleau de l’université de Carnegie Mellon a créé ALVINN (Autonomous Land Vehicle In a Neural Network), un véhicule financé par l’armée, capable de fonctionner de manière autonome mais limitée grâce à un système de contrôle informatique.

Les années 1990 et le début des années 2000

Des bots tournés vers le consommateur

La décennie suivante a amorcé un changement majeur qui s’est manifesté au travers de bots de plus en plus tournés vers le consommateur. Certains des premiers jeux vidéo sont souvent considérés comme des robots rudimentaires de grande consommation, surtout ceux dans lesquels il fallait saisir des commandes pour progresser.

On peut aussi citer comme exemple le Tamagotchi de 1996. Bien qu’il n’ait pas été expressément qualifié de bot, il offrait une interaction semblable. Il s’agissait d’un animal de compagnie électronique de poche, qui demandait des soins virtuels inspirés de la réalité. Il fallait par exemple le nourrir, jouer avec lui et lui faire faire ses besoins.

Au cours des années 1990, l’intelligence et les aptitudes des machines se sont développées, à tel point que les robots ont pu participer de manière autonome à des compétitions sportives. Parmi les exemples les plus notoires, citons celui de la première RoboCup de 1997, un tournoi dans lequel 40 équipes formées uniquement de robots se sont affrontées lors de matchs de football de table.

SmarterChild et autres inventions

L’an 2000 a marqué un tournant dans le domaine de la communication entre êtres humains et robots. C’est cette année-là qu’est sorti SmarterChild de l’entreprise ActiveBuddy, un programme intégré dans la liste d’amis de la messagerie instantanée d’AOL.

Sa programmation contenait un stock de réponses pré-définies pour tout un éventail de requêtes. À certains égards, il s’agissait d’une version très rudimentaire des outils de recherche vocale tels que Siri.

Google était déjà disponible et Yahoo! était en position de force, mais il fallait tout de même plusieurs minutes pour trouver une information. Avec SmarterChild, il suffisait d’écrire « Quel score a fait l’équipe de football de Chicago hier soir ? » et la réponse apparaissait dès vous appuyiez sur Entrée, une fonctionnalité épatante à l’époque.

Cette technologie a suffi à justifier l’achat de l’entreprise ActiveBuddy par Microsoft, mais cette dernière a toutefois rapidement abandonné le projet SamrterChild.

Le début du millénaire a également vu de nouvelles avancées dans le domaine des voitures autonomes. Ainsi, Stanley, un robot-automobile inventé à Stanford, a été le premier de son genre à participer au défi de DARPA, à savoir une course de près de 230 km dans le désert de Mojave, à terminer en moins de 10 heures.

Les années 2000 ont servi de catalyseur aux progrès majeurs des bots dans un contexte de popularité croissante des smartphones. Tout a commencé lorsque les développeurs ont été forcés de tronquer leurs sites web pour s’adapter à des écrans plus petits. Cela a soulevé des questions liées à l’ergonomie et à la réactivité. De nouvelles interfaces ont permis d’interagir avec les bots comme s’il s’agissait de vraies personnes et la recherche vocale a fait son apparition.

2011 et au-delà

La recherche vocale a engendré un développement rapide des bots auprès des consommateurs grâce à l’introduction de l’assistant personnel intelligent. Avant cela, la société iRobot figurait parmi les marques de référence dans le secteur de l’intelligence artificielle. L’entreprise avait fait ses débuts en tant que prestataire dans le secteur de la défense pour finalement se réorienter dans la fabrication d’un robot ménager, le Roomba.

Toutefois, il n’était pas possible de communiquer sur le plan verbal avec cette machine : ses fonctions se limitaient au nettoyage des sols. Aussi, la sortie de Siri en 2011, un outil capable de répondre aux questions sur demande, directement depuis le téléphone et sans consulter un moteur de recherche, a changé la donne.

Cette nouvelle technologique, qui pouvait encore être améliorée, allait générer un nouvel attrait sur le marché des technologies d’assistance vocale.

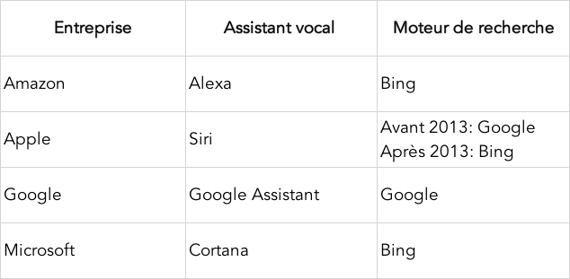

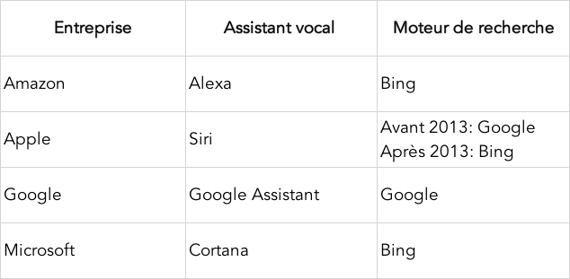

Aujourd’hui, il existe quatre piliers dans ce domaine :

Très vite, les fabricants ont combiné la recherche vocale à l’internet des objets pour contrôler à distance les appareils, l’éclairage, les systèmes de sécurité, etc.

Amazon a lancé Echo seulement trois ans après la sortie de Siri, son bot nommé Alexa répond non seulement aux questions concernant la météo et la conversion des unités de mesure, mais gère aussi l’automatisation du foyer. Google est également entré sur le marché avec la sortie de Google Home en 2015.

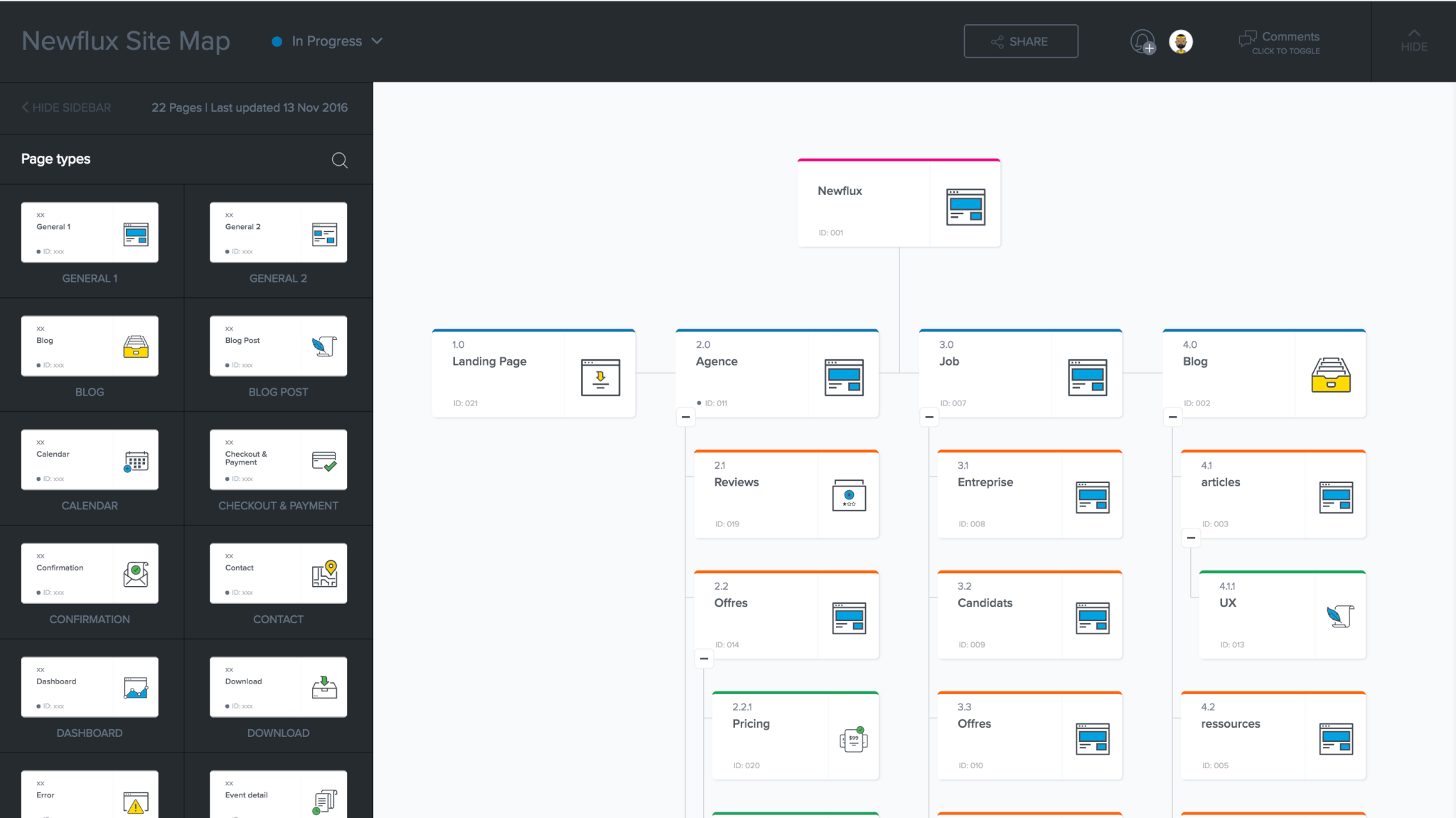

L’accent est désormais mis sur le service. Les robots ne sont plus seulement utilisés pour la recherche vocale et d’autres formes d’assistance personnelle. En effet, les entreprises ont commencé à les inclure dans leur service client. En avril 2016, Facebook a annoncé les nouvelles capacités d’intégration de sa plateforme Messenger avec des chatbots.

Ces derniers seraient à même de fournir des contenus automatisés accessibles sur abonnement, comme des informations relatives à la météo ou au trafic, mais également des communications personnalisées telles que des reçus, des notifications de livraison ou des messages automatisés en direct, tout cela en interagissant directement avec l’utilisateur.

Certaines technologies introduites par MYCIN et INTERNIST-1 ont été remises au goût du jour. Par exemple, Healthtap utilise une base de données médicales pour répondre aux questions des utilisateurs sur les symptômes qu’ils ressentent.

Cela étant, toutes les avancées énumérées ci-dessus ne représentent que la partie émergée de l’iceberg. Il existe actuellement tellement d’applications possibles pour les robots qu’il est quasiment impossible d’en dresser une liste complète.

Ce n’est qu’un début…

La sortie de l’AI Olly a été annoncée comme un assistant personnel disposant des mêmes capacités que Google Home et Echo, mais doté d’une personnalité unique : la vôtre.

Les bots sont désormais conçus pour observer le comportement et écouter la façon dont vous parlez pour ensuite l’imiter. Qu’il s’agisse des plats que vous commandez, des livres que vous lisez ou des expressions que vous utilisez, Olly est capable d’assimiler ces informations et de les retenir.

Cette invention montre que des idées qui appartenaient autrefois au monde de la science-fiction deviennent rapidement une réalité. Si la robotique suscite toutes sortes de réactions favorables ou négatives, elle reste néanmoins un sujet captivant.

Pour débuter à votre propre niveau et utiliser les bots dans votre stratégie marketing, découvrez comment créer votre propre bot avec cet e-book gratuit.

Blog Hubspot.